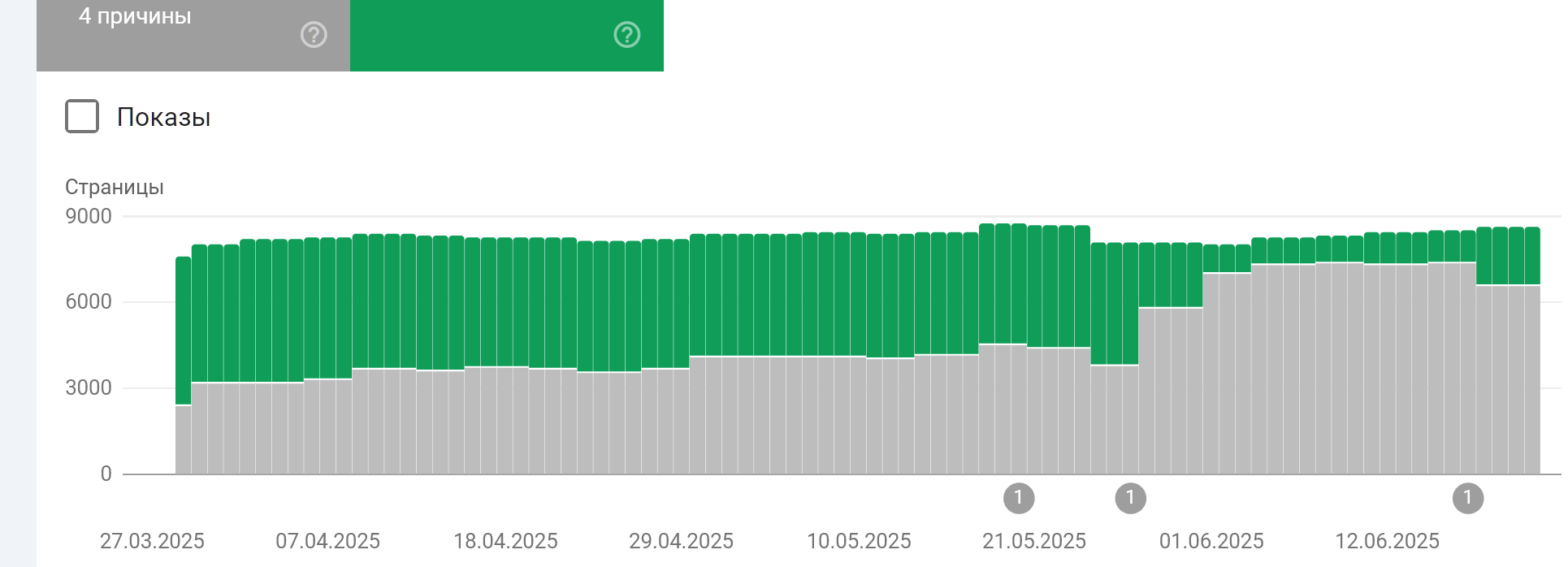

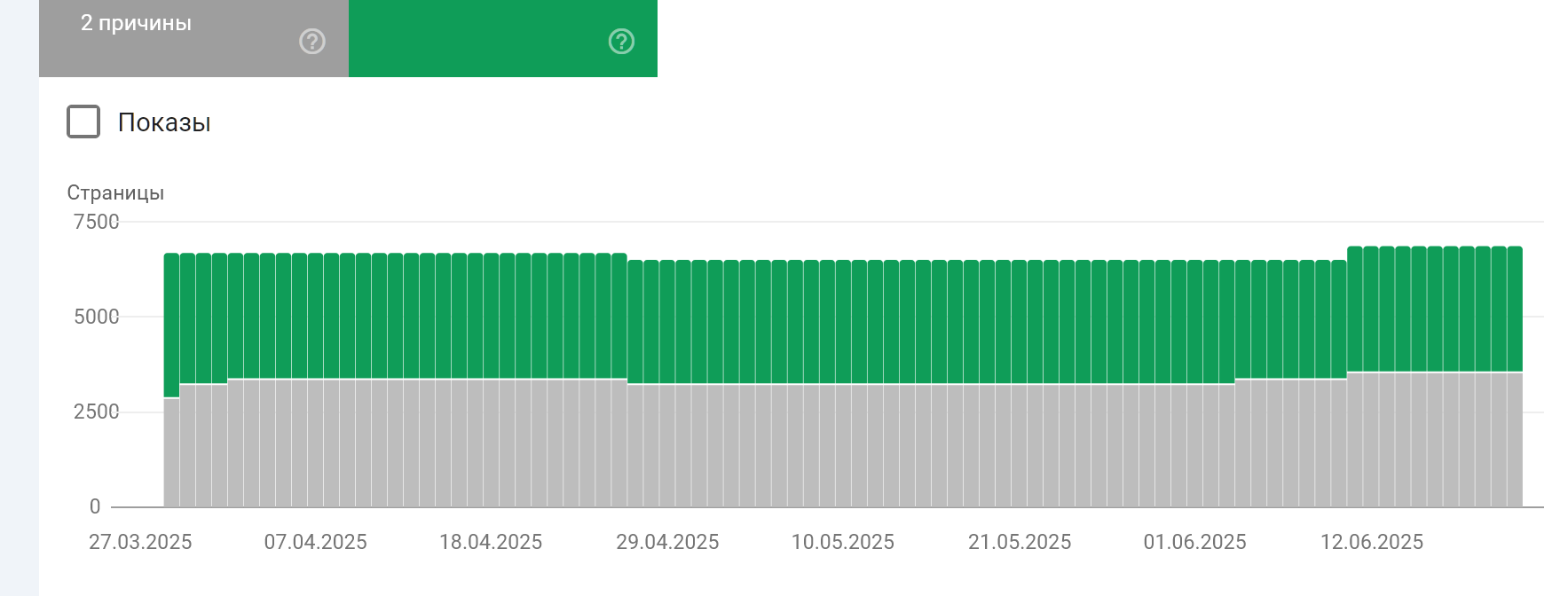

С 29 мая Google начал внедрять алгоритм, который деиндексирует лишние, по его мнению, страницы сайтов и забирает рейтинг с их уменьшением. Даже топы попали под его воздействие и достаточно ощутимо.

Что делать чтобы не терять страницы в индексе Google

Мы сразу начали различные тесты по противодействию этому алго. В данный момент, алгоритм еще сырой и защититься от него достаточно просто, но его явно будут дорабатывать и возможно дальнейшие его апгрейды уже будет не так просто обойти.

Самыми сильными показателями вылета у этого алгоритма являются:

- 1. Глубина страницы на сайте (слишком далеко от главной и тяжелых хаб страниц);

- 2. Не посещаемые страницы слишком длительное время;

- 3. Устаревший по дате контент, который не меняется (даже если он и находится близко к главной).

Мы использовали различные комбинации противодействия, но оптимальными и не затратными приняли к действию:

- 1. Ротация глубоких страниц через хабы и главную страницу (от 10 до 24 часов на ссылку в позиции на главной и хабе);

- 2. Одиночное-двойное бото-посещение страницы;

- 3. Для дата-зависимых страниц изменение даты методом добавления новых фактов в контент страницы по этой тематике (R и S модели справляются с этим на ура простейшими промптами).

Если не пытаться защищаться от этого алгоритма, то он начинает писать ошибки в индексировании в консоли в ключевые моменты внедрения витков этого алгоритма, чем вводит в заблуждение вебмастеров, так как эти ошибки не имеют отношения к реальной картине произошедшей деиндексации.