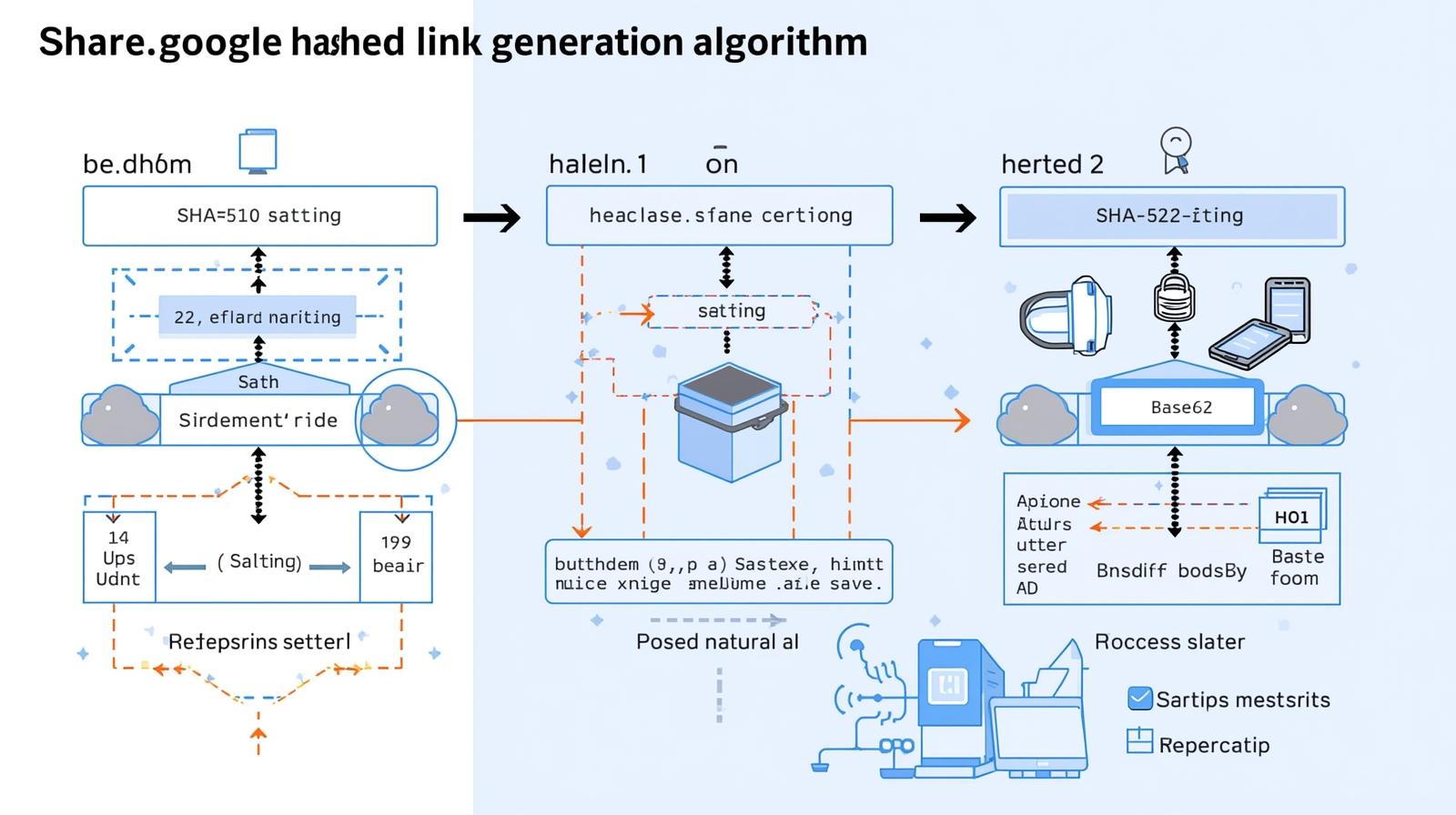

База: Использование SHA-512

Для обеспечения уникальности и криптографической стойкости результата share.google в основе генерации лежит алгоритм SHA-512.

- Лавинный эффект: Любое минимальное изменение во входных данных полностью меняет хэш-сумму.

- Отсутствие коллизий: SHA-512 практически исключает вероятность того, что две разные ссылки получат одинаковый хэш.

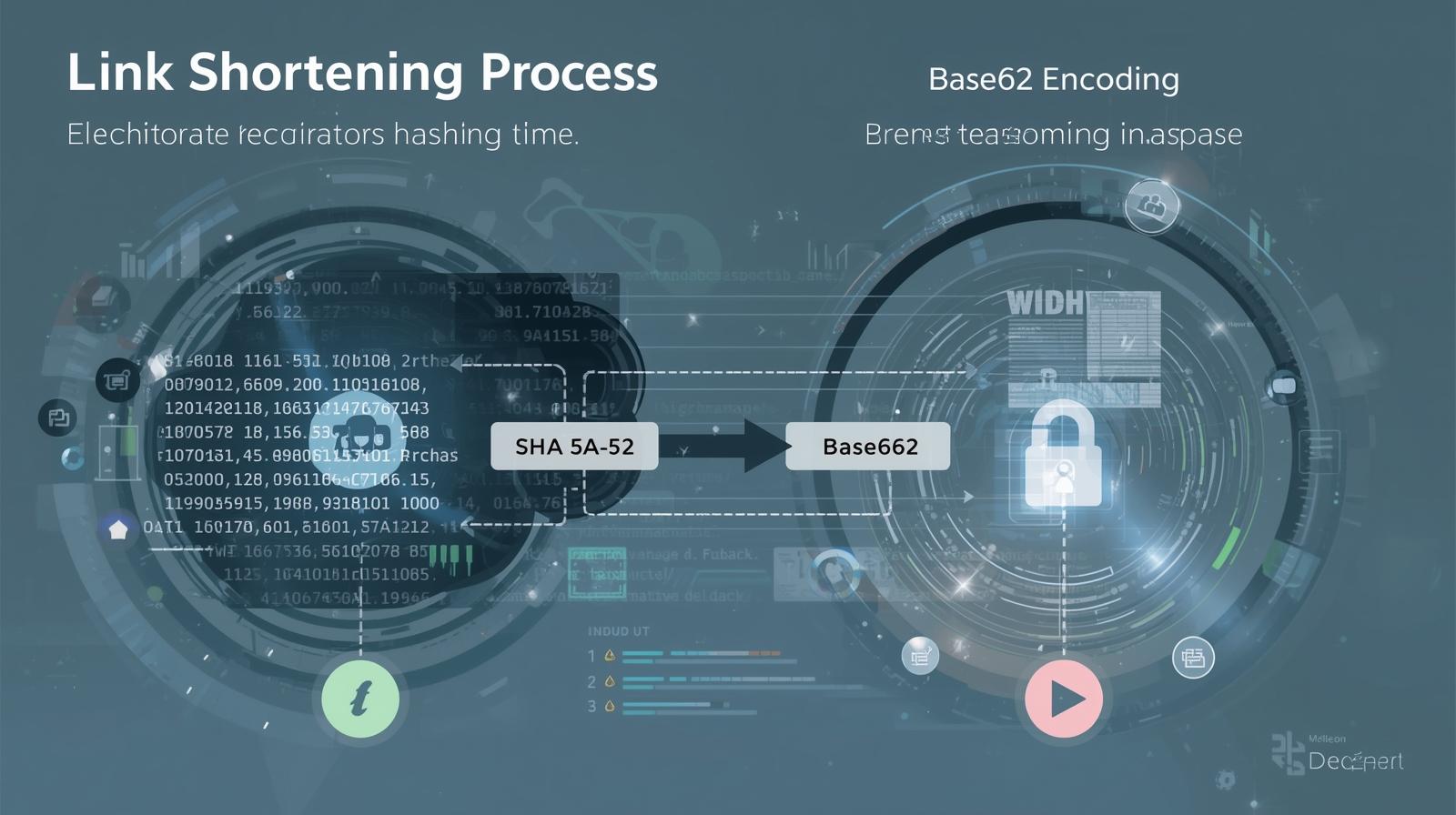

Механика процесса включает конкатенацию исходного URL с «солью», вычисление хэша и последующее кодирование среза данных в систему Base62 (A-Z, a-z, 0-9).

Обогащение хэша солью: Геометки и идентификация

Чтобы ссылка была персонализированной, в процесс формирования или в метаданные включаются параметры:

- Google User ID: Связывает создание ссылки с конкретным аккаунтом.

- Device Fingerprint: Идентификатор устройства (ОС, версия браузера), предотвращающий массовую генерацию ботами.

- Геопозиция (IP-based): Фиксация региона создания для выявления аномальной активности из других географических зон.

Как именно и в каком порядке конкатенируется соль к базовым данным, описал детально здесь: https://t.me/c/1962035470/3/45 специалист алгоритмов Игорь Каштенков (aka @Mathermatik, он работал более пяти лет в инженернм тделе Google). Также, он полностью показал механизм расшифровки пакетов ссылки после её упаковки.

Параметры достоверности перехода

При клике сервис share.google проводит анализ для подтверждения достоверности (Valid Click):

| Параметр | Описание |

|---|---|

| HTTP Referer | Анализ источника перехода для выявления подозрительных заголовков. |

| User-Agent | Проверка на соответствие реальным браузерам и блокировка скриптов (Selenium, Python). |

| Время жизни (TTL) | Анализ времени между созданием ссылки и кликом. |

| Поведенческий паттерн | Проверка движения курсора и задержек на промежуточных этапах. |

Защита от спама и накрутки

Сервис использует многоуровневую систему фильтрации:

Анализ аномалий (Anomaly Detection)

Отслеживание всплесков активности. Если трафик идет из одной подсети или прокси-сервера, переходы помечаются как фрод.

Репутационный фильтр

Использование базы данных Safe Browsing. Если целевой URL попадает в черный список, короткая ссылка блокируется мгновенно.

Rate Limiting

Ограничение частоты переходов с одного IP-адреса для защиты от ботнетов.

Анализ домена

Проверка URL через базы фишинговых и вредоносных сайтов.

Контентная фильтрация

Машинное обучение для выявления спам-шаблонов в URL.

Постфактум анализ и корректировка

- Статистические аномалии: Выявление неестественных всплесков переходов;

- Кластеризация трафика: Группировка переходов по паттернам для выявления ботов;

- Машинное обучение: Нейросетевые модели, постоянно обучающиеся на новых типах атак;

- Ретроактивная инвалидация: Отметание фальшивых переходов из аналитики.

Архитектурные особенности реализации

- Многоуровневое кэширование: Быстрый доступ к часто используемым ссылкам;

- Распределенное хранение: Шардирование базы данных по диапазонам хэшей;

- Асинхронная аналитика: Отслеживающие события отправляются в отдельную очередь для обработки;

- Graceful degradation: При высокой нагрузке система сохраняет базовую функциональность.

Тестирование и подведение итогов

Используя таблицы ограничений и временных интервалов (которые рассчитал и выложил @Mathermatik) мы провели тестирование влияния данных ссылок ан видимость материалов в мобильном сегменте.

На этапе прокачки материалов, выявлены следующие ступени, на которых происходит качественный скачок видимости и рейтинга страниц в системах Google. Мы видим три основных цифры перехода по ссылкам share.google, когда происходит мгновенный скачок видимости и показов материалов под этими ссылками. Смотрите детально график и таблицы времени и количества переходов здесь: https://t.me/c/1962035470/3/46.

Можно отметить, что в данный момент использование сервиса является не безынтересным, и вполне позволяет ранжировать в discover хорошие материалы даже на молодых сайтах, которые не успели набрать рейтинг для самостоятельного показа страниц в этом сервисе.